当我们在谈论AI强大和便利时,不可避免地会对其潜在的风险和危害感到担忧和害怕。

而现在,最让我们担忧的事情终于开始大规模发生了。

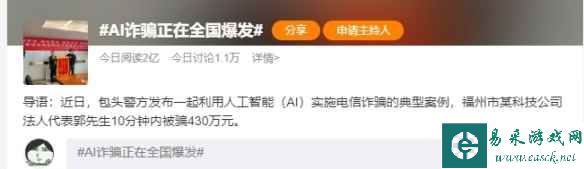

这两天,有关“AI诈骗”的事件冲上了微博热搜,引起了不少关注。

这件事发生在福州市一位科技公司的法人代表郭先生身上。

4月20号中午,郭先生突然接到了“好友”的微信电话。

对方表示自己正在外地竞标,需要430万保证金,并且要公对公转账(公司对公司的转账),所以想要借郭先生公司的账户走个账。

因为对方是通过微信电话的方式交流的,而且从郭先生的视角来看,这位朋友无论从面容还是声音来看都没什么不对劲的地方。

所以基于对朋友的信任,他没有犹豫的就给自己的朋友转账了。

——于是这位郭先生就在短短10分钟之内被骗走了430万元。

这件事情说新鲜其实也不算新鲜,因为一直以来电信诈骗的案例不在少数。

而这两年国家反诈中心也一直在推广和宣传反诈活动,通过加强大家的反诈意识,也的确有效的减少了此类事情的发生频率。

当然还是有很多被骗的人

但这事儿可怕就可怕在——

骗子们利用了“AI技术”来实施诈骗,并且达到了以假乱真的程度。

从这件事情来看,骗子极有可能是先盗取了对方好友的微信,再利用AI换脸技术和AI声音技术佯装好友实施诈骗。

相信不少人已经对两项AI技术非常眼熟了。

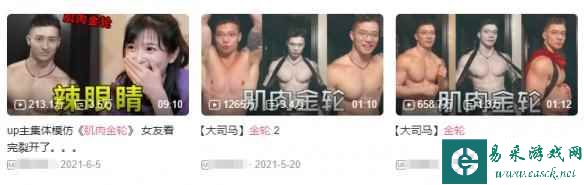

事实上,从去年开始,有关AI换脸的视频就已经在网络上风靡了一段时间。

而随着AI技术的不断突破,到现在这个技术已经更为成熟,甚至还能做到像这件诈骗事件一样,和对方进行实时互动。

曾风靡B站一段时间的大司马换脸视频

对于AI换声技术来说,我想最近大火的“AI孙燕姿”也是一个很好的例子。

通过AI技术合成的人声,基本上和原声有着90%的相似度,不仔细听根本听不出区别;

更重要的是,这项技术也没有任何门槛可言——只要能够收集到足够多对方的声音片段,你就能生成任何想要说的话。

而这个技术,对于电话诈骗可是再合适不过了。

或许很多人都具有一定的反诈骗意识,但是在如此高明的“新型诈骗”面前,我想也有不少人会被这种手段所欺骗。

所以在这里我还是要提醒大家,如果近期有朋友要向你借钱,并且金额还不小的话,一定要慎重慎重再慎重。

说个题外话——

十分钟,就能让朋友转几百万,这样的朋友那里找啊(不是)

提示:支持键盘“← →”键翻页 0